Na czym polega audyt on-site SEO? 10 podstawowych rzeczy do sprawdzenia

Audyt on-site SEO – co to tak właściwie jest?

Audyt on-site SEO to proces analizy i oceny strony internetowej pod kątem jej optymalizacji pod wyszukiwarki internetowe. Celem audytu jest zidentyfikowanie i naprawa błędów technicznych, które mogą wpływać na widoczność strony w wynikach wyszukiwania. Audyt techniczny SEO ma na celu poprawę indeksowania strony przez roboty wyszukiwarek, zoptymalizowanie struktury i architektury strony, a także usunięcie wszelkich czynników blokujących lub utrudniających indeksowanie treści przez wyszukiwarki. Dodatkowo dobrze przeprowadzone wdrożenia zmian z wcześniej wykonanego audytu on-site mogą pozytywnie wpłynąć na pozycje naszych podstronach w wynikach wyszukiwania.

Kiedy wykonać audyt SEO?

Audyt SEO można wykonać w dowolnym momencie, ale istnieją pewne sytuacje, w których przeprowadzenie audytu jest szczególnie zalecane. Oto kilka takich przypadków:

- Przed rozpoczęciem optymalizacji: Jeśli dopiero zaczynasz pracować nad optymalizacją strony pod kątem SEO, audyt może pomóc zidentyfikować obszary wymagające poprawy. Dzięki temu będziesz miał jasny obraz dotychczasowej sytuacji i będziesz mógł skoncentrować się na najważniejszych aspektach.

- Po zmianach na stronie: Jeśli wprowadziłeś znaczące zmiany na stronie, takie jak zmiana struktury URL, przeniesienie na inny system zarządzania treścią lub aktualizacja projektu graficznego, warto przeprowadzić audyt SEO, aby upewnić się, że zmiany te nie wpłynęły negatywnie na widoczność i pozycje strony w wynikach wyszukiwania.

- Spadek ruchu i pozycji w wynikach wyszukiwania: Jeśli zauważasz nagły spadek ruchu na stronie lub pogorszenie pozycji w wynikach wyszukiwania, audyt SEO może pomóc zidentyfikować potencjalne problemy, które przyczyniają się do tej sytuacji. Może to obejmować czynniki techniczne, zawartość i inne aspekty, które mogą mieć wpływ na widoczność strony.

- Przed restrukturyzacją strony: Jeśli planujesz przeprowadzić znaczące zmiany strukturalne na stronie, na przykład zmianę URL, przeniesienie na nową platformę lub zmianę hierarchii stron, audyt SEO może pomóc zidentyfikować potencjalne zagrożenia i odpowiednio przygotować się do restrukturyzacji, aby minimalizować ryzyko utraty ruchu organicznego.

Pomocne narzędzia przy przeprowadzaniu audytu on-site SEO

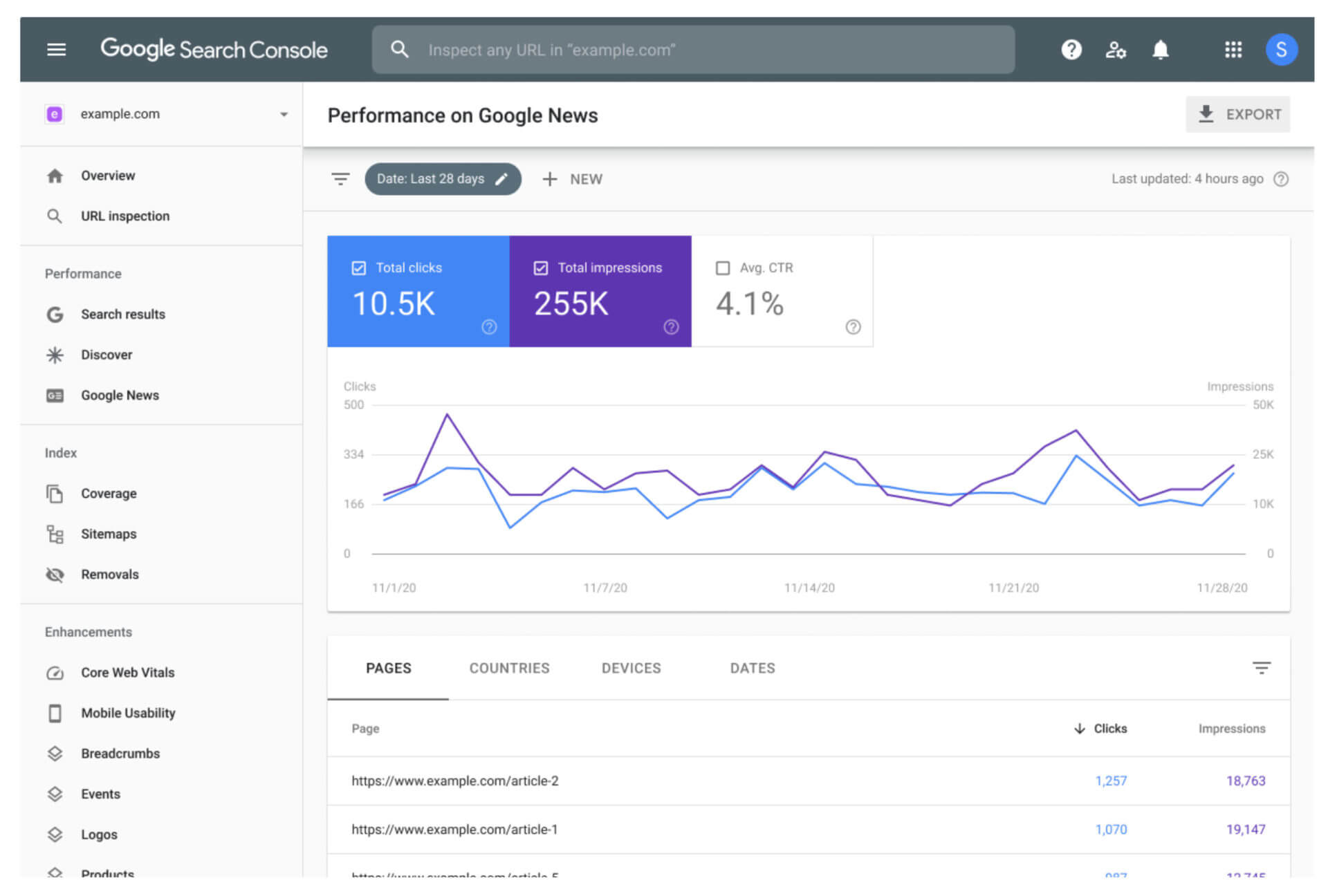

Google Search Console

Google Search Console to darmowe narzędzie od Google, które pozwala monitorować i raportować o wydajności Twojej strony w wyszukiwarce Google. Możesz tu sprawdzić, jakie strony są indeksowane przez Google, jakie błędy są na stronie, jakie są frazy kluczowe generujące ruch na stronę i wiele innych.

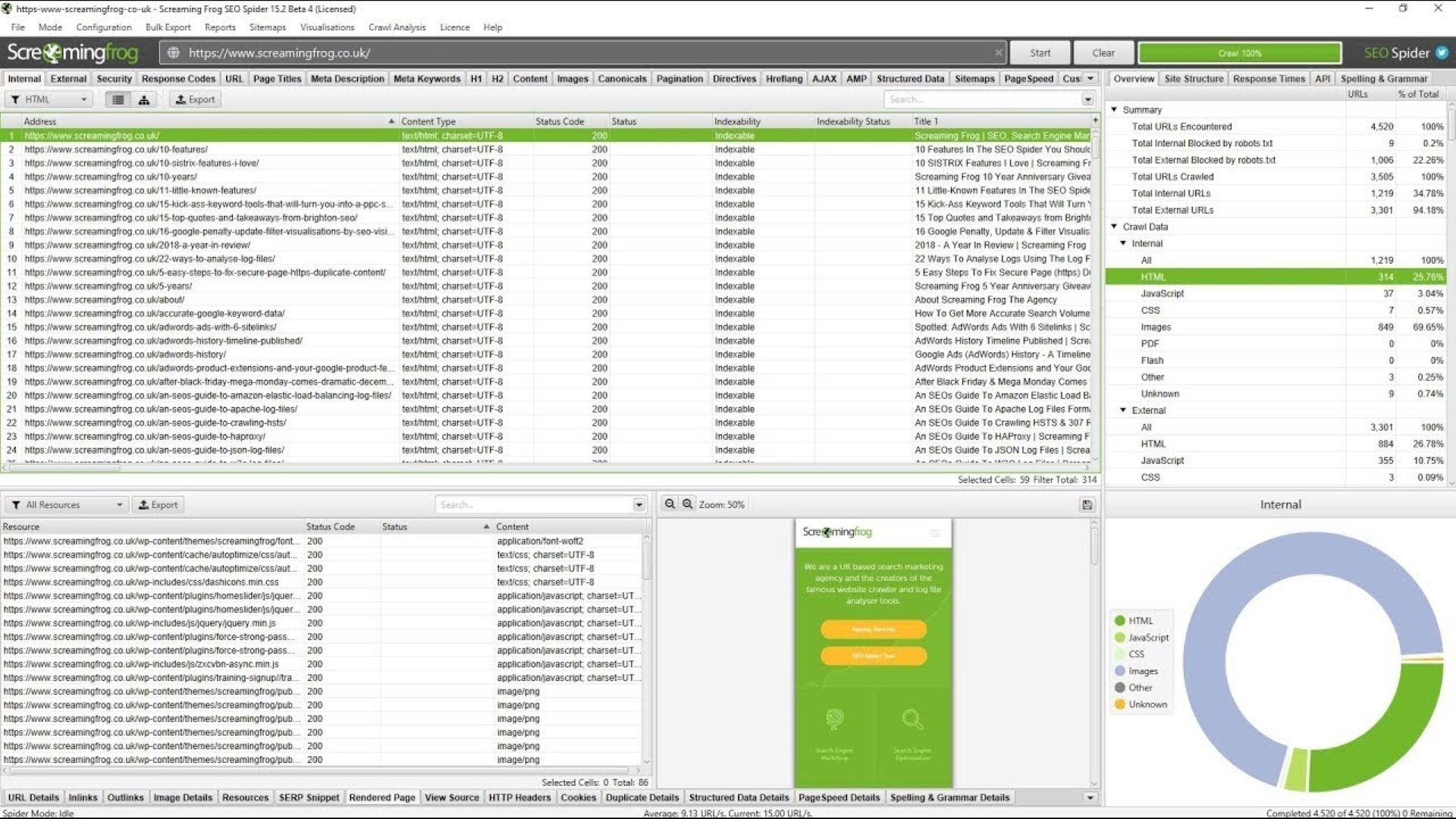

Screaming Frog SEO Spider

Screaming Frog to bardzo popularne narzędzie do audytu SEO, które pozwala na szybkie przeprowadzenie crawlowania stron. Pozwala ono na identyfikację problemów z tytułami i opisami meta, nagłówkami, linkami, statusami odpowiedzi serwera, atrybutami alt obrazów, itp.

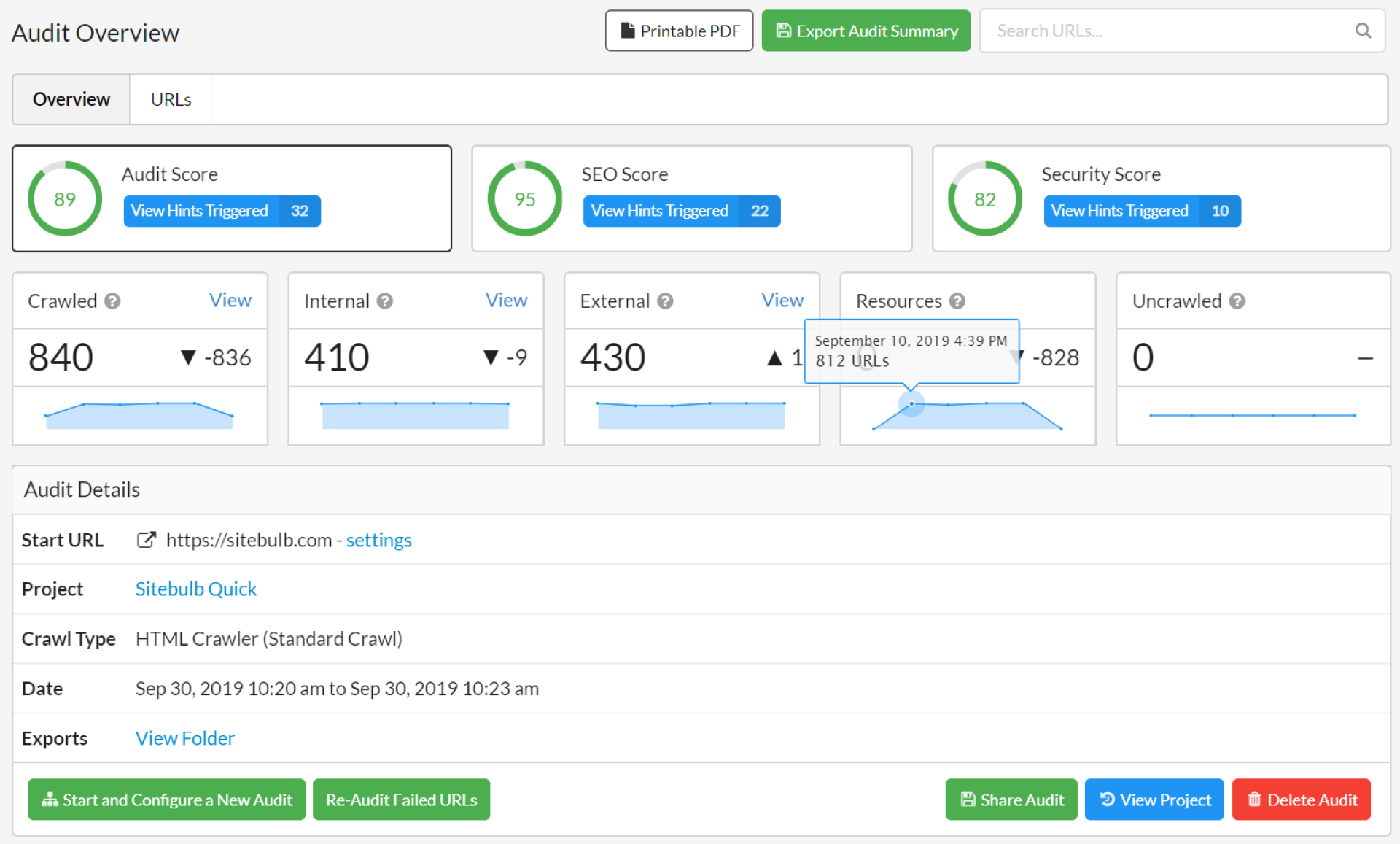

Sitebulb

Sitebulb to zaawansowane narzędzie do analizy stron internetowych i audytu SEO. Jest zaprojektowane tak, aby pomóc specjalistom SEO, webmasterom i agencjom marketingowym w zrozumieniu i optymalizacji witryn internetowych. Sitebulb oferuje szeroki zakres funkcji i możliwości, które umożliwiają kompleksową analizę techniczną witryny.

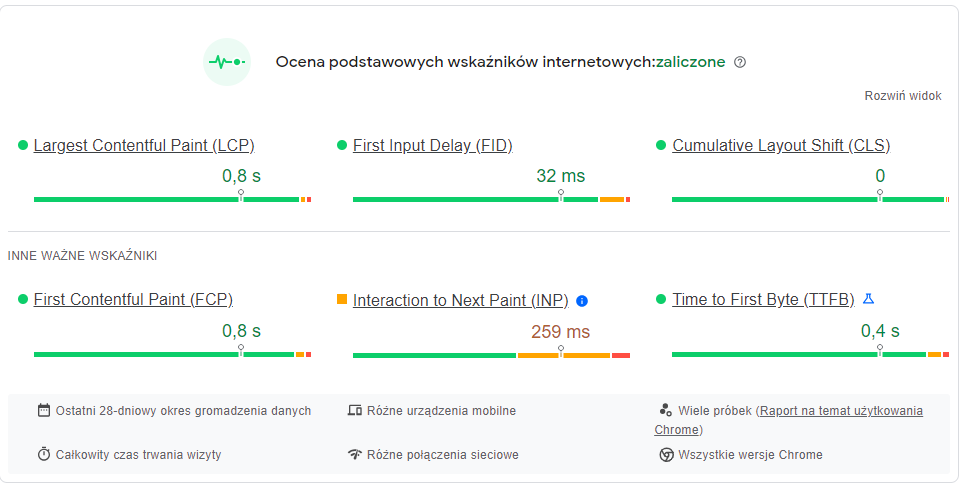

Google PageSpeed Insights

Google PageSpeed Insights to narzędzie dostarczane przez Google, które służy do analizowania wydajności stron internetowych i oceny ich optymalizacji pod kątem prędkości wczytywania i użytkowania na urządzeniach mobilnych oraz desktop. Narzędzie to pomaga twórcom stron internetowych i deweloperom w identyfikowaniu potencjalnych problemów, które mogą wpływać na szybkość i wydajność strony.

PageSpeed Insights analizuje stronę internetową na podstawie różnych czynników, takich jak czas wczytywania, dostępność na urządzeniach mobilnych, optymalizacja obrazów, kompresja zasobów, wykorzystanie pamięci podręcznej przeglądarki, eliminacja renderowania blokującego, optymalizacja kodu HTML, CSS i JavaScript, i wiele innych.

Po analizie strony, narzędzie generuje wynik w postaci dwóch ocen: jedną dla wersji desktopowej i drugą dla wersji mobilnej strony. Oceniane są różne czynniki wydajnościowe, a wyniki są przedstawiane w formie punktowej oceny od 0 do 100. Wyższe punkty oznaczają lepszą optymalizację i wydajność strony.

Dodatkowo, Google PageSpeed Insights udostępnia szczegółowe informacje i sugestie dotyczące optymalizacji strony. Wskazuje, które elementy strony wymagają poprawy i sugeruje konkretne kroki, jakie można podjąć w celu zoptymalizowania prędkości wczytywania strony. Może to obejmować zmniejszenie rozmiaru obrazów, skompresowanie plików, zmianę kodu strony lub inne działania mające na celu usprawnienie wydajności strony.

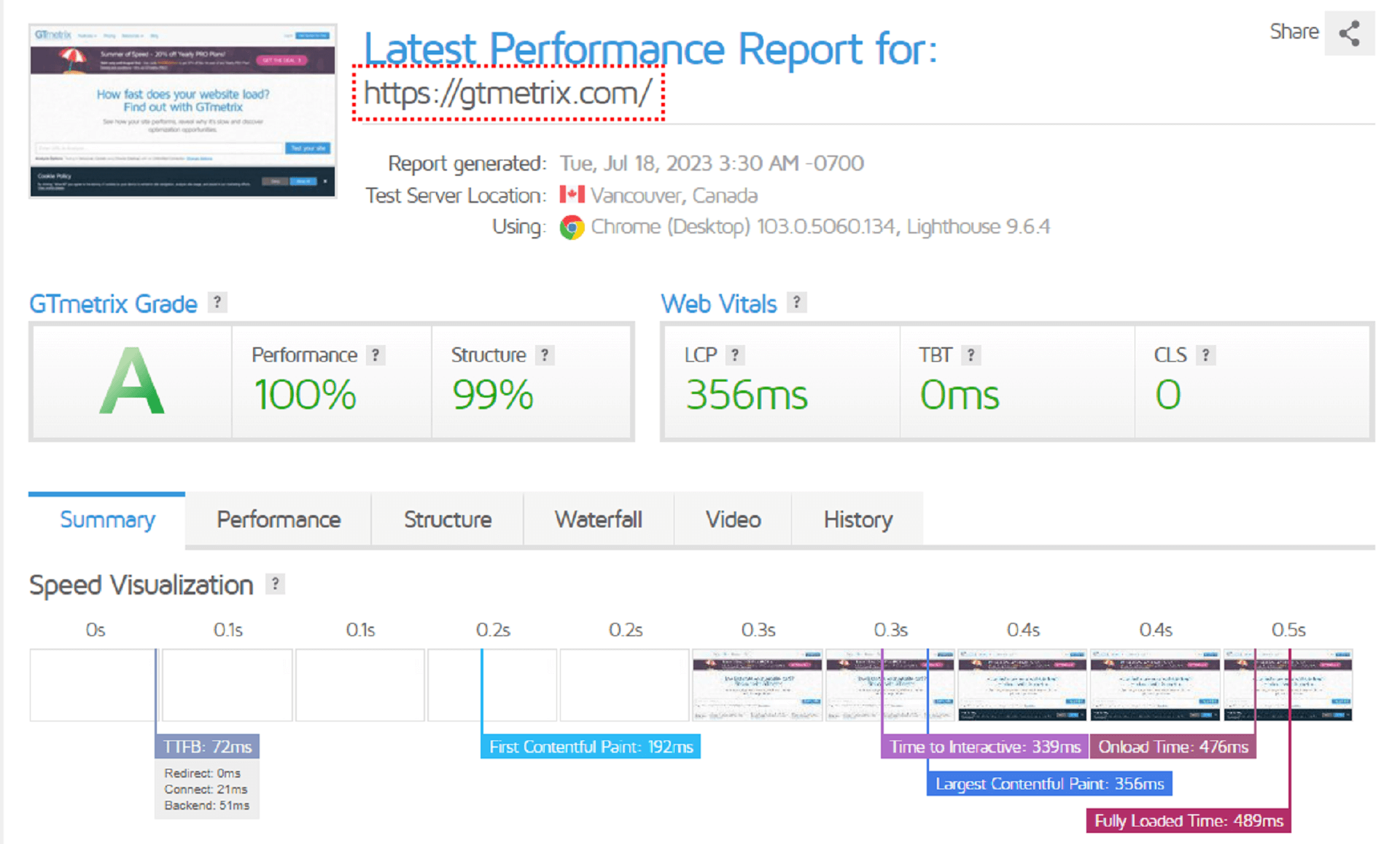

GTMetrix

GTMetrix to internetowe narzędzie analizujące wydajność i optymalizację strony internetowej. Jest powszechnie stosowane przez webmasterów, deweloperów i właścicieli stron do monitorowania i oceny szybkości ładowania stron oraz identyfikowania obszarów, które można zoptymalizować w celu poprawy doświadczenia użytkownika.

Narzędzie GTMetrix pozwala na testowanie stron internetowych na podstawie różnych kryteriów, takich jak czas ładowania, rozmiar plików, liczba zapytań HTTP i wiele innych.

10 podstawowych rzeczy do sprawdzenia podczas wykonywania audytu on-site

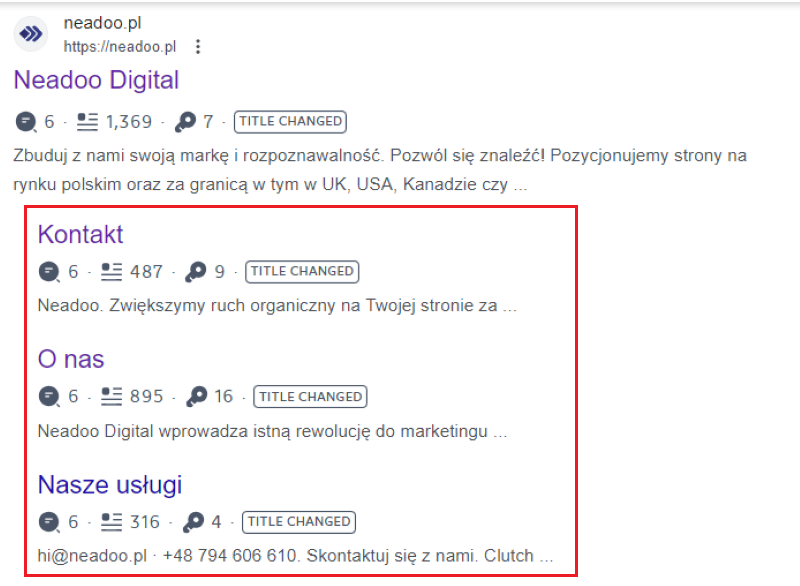

Meta tytuł i opis strony

Meta tytuł i meta opis są często wykorzystywane jako podstawowe elementy informacyjne wyświetlane w wynikach wyszukiwania. Dobrze zoptymalizowane i atrakcyjne meta tytuły oraz meta opisy mogą zwiększyć współczynnik klikalności (CTR) Twojej strony, ponieważ przyciągają uwagę użytkowników i zachęcają do kliknięcia. Meta tytuły i opisy strony muszą być unikalne dla każdej podstrony. Meta tytuł powinien zawierać odpowiednie kluczowe słowa związane z treścią strony. Jeśli użytkownik wpisuje zapytanie związane z tymi słowami, a meta tytuł jest zgodny z tymi słowami, istnieje większe prawdopodobieństwo, że Twoja strona zostanie uwzględniona w wynikach wyszukiwania.

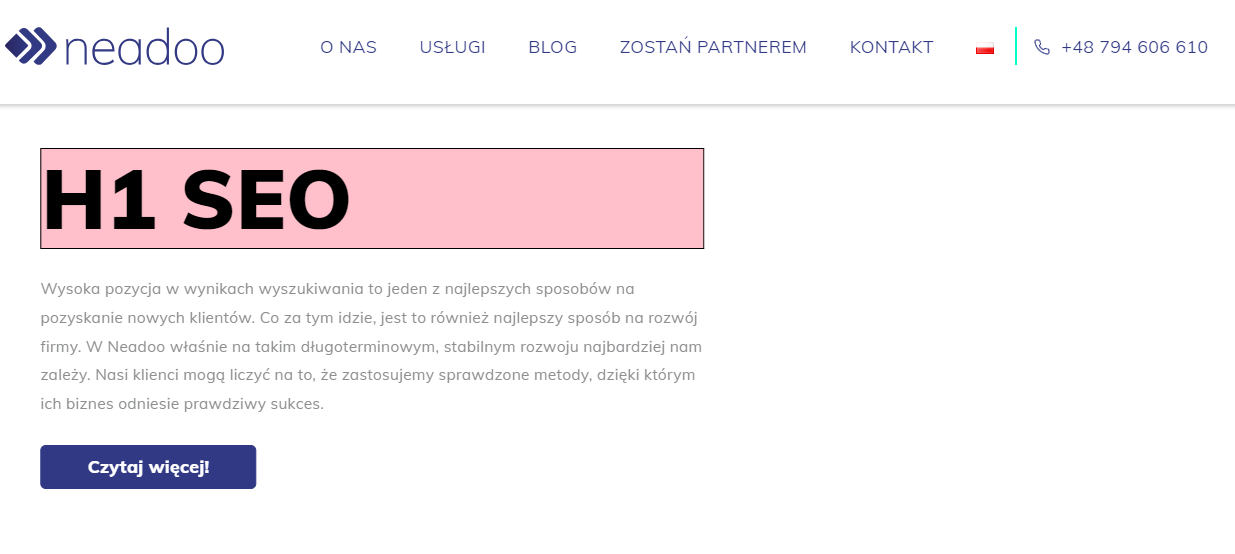

Nagłówki i ich struktura

Nagłówki są używane do strukturyzacji i hierarchizacji treści na stronie internetowej. Warto zauważyć, że wyszukiwarki internetowe preferują dobrze zorganizowane strony, które mają logiczną strukturę. Poprawna hierarchia nagłówków (np. H1, H2, H3 itd.) pomaga zrozumieć, jak treść jest zorganizowana i jakie elementy są najważniejsze. To ułatwia indeksowanie i interpretację zawartości przez wyszukiwarki. Nagłówki są ważne nie tylko dla robotów wyszukiwarek, ale także dla użytkowników strony internetowej. Dobrze sformatowane nagłówki ułatwiają czytanie i nawigację po treści. Pomagają w szybkim skanowaniu strony, umożliwiając użytkownikom znalezienie interesujących ich informacji. Należy pamiętać, aby występował tylko jeden nagłówek typu H1 na podstronie i był on unikalny, czyli nie powtarzał się na innych podstronach w obrębie naszego serwisu.

Optymalizacja szybkości działania strony

Szybkość działania strony jest jednym z czynników, które Google bierze pod uwagę podczas indeksowania i oceny stron pod kątem jakości. W 2010 roku Google ogłosił, że szybkość ładowania strony jest oficjalnym czynnikiem rankingowym. Im szybciej strona się ładuje, tym większe są szanse na lepsze pozycjonowanie w wynikach wyszukiwania. Google ma na celu dostarczenie użytkownikom najlepszych doświadczeń, dlatego strony, które są szybkie i responsywne, zyskują przewagę w rankingu. Badania wykazują, że użytkownicy są bardziej skłonni pozostać na stronie, która szybko się ładuje. Jeśli strona jest wolna w działaniu i wymaga długiego czasu ładowania, użytkownicy mogą zniechęcić się i opuścić ją, szukając alternatywnych, bardziej responsywnych stron. To z kolei może prowadzić do wyższej wskaźnika odrzutu (bounce rate) i niższej liczby odwiedzin, co negatywnie wpływa na pozycjonowanie strony w wynikach wyszukiwania.

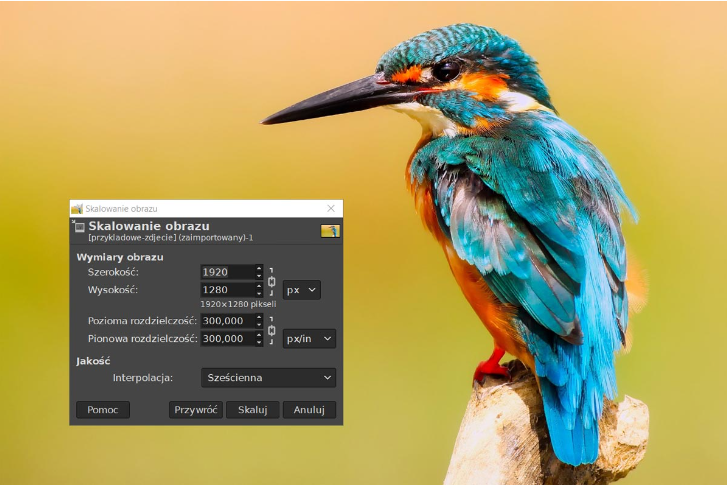

Optymalizacja grafik

Grafiki mogą znacząco wpływać na czas ładowania strony. Im większe rozmiary plików graficznych, tym dłużej zajmuje ich pobieranie przez przeglądarkę. Jeśli strona internetowa ma długie czasy ładowania, może to negatywnie wpływać na doświadczenie użytkowników oraz na ranking strony w wynikach wyszukiwania. Wyszukiwarki, takie jak Google, preferują strony o krótkim czasie ładowania, dlatego ważne jest optymalizowanie grafik w celu zmniejszenia rozmiaru plików i poprawy wydajności strony. Warto skorzystać z nowych formatów dla grafik takich jak .webp oraz .avif.

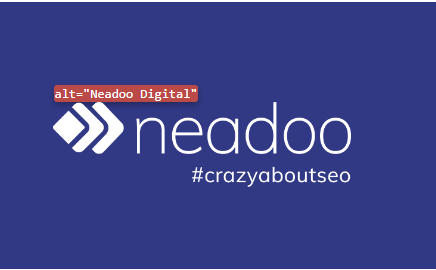

Atrybuty ALT grafik

Wyszukiwarki, takie jak Google, nie są w stanie „zobaczyć” obrazów, ale korzystają z tekstu, aby zrozumieć, o czym jest dana strona. Poprzez dodanie atrybutów ALT, dostarczasz wyszukiwarkom dodatkowe informacje o treści obrazów na swojej stronie. To może pomóc w lepszym indeksowaniu i pozycjonowaniu Twojej witryny w wynikach wyszukiwania. Atrybuty ALT są kluczowe dla osób korzystających z czytników ekranowych lub mających wyłączoną możliwość wyświetlania obrazów. Dzięki wprowadzeniu odpowiedniego alternatywnego tekstu, osoby te mogą zrozumieć, czym jest dany obraz i jakie informacje w nim zawarte. Warto umieścić w atrybucie ALT frazę kluczową, jeśli jest taka możliwość.

Dane strukturalne

Dane strukturalne to specjalne oznaczenia, które można dodać do kodu źródłowego strony internetowej w celu dostarczenia wyszukiwarkom dodatkowych informacji na temat treści prezentowanej na stronie. Dane strukturalne pozwalają wyszukiwarkom lepiej zrozumieć zawartość strony i kontekst, w którym się znajduje. Dzięki temu wyszukiwarki mogą lepiej zinterpretować informacje i wyświetlać bardziej precyzyjne i odpowiednie wyniki w wynikach wyszukiwania. Dane strukturalne umożliwiają wyświetlanie dodatkowych informacji o stronie w wynikach wyszukiwania. Na przykład, jeśli doda się dane strukturalne o recenzjach produktów, można oczekiwać, że w wynikach wyszukiwania pojawią się gwiazdki oceny, liczba recenzji i inne szczegóły, które przyciągają uwagę użytkowników i zwiększają klikalność.

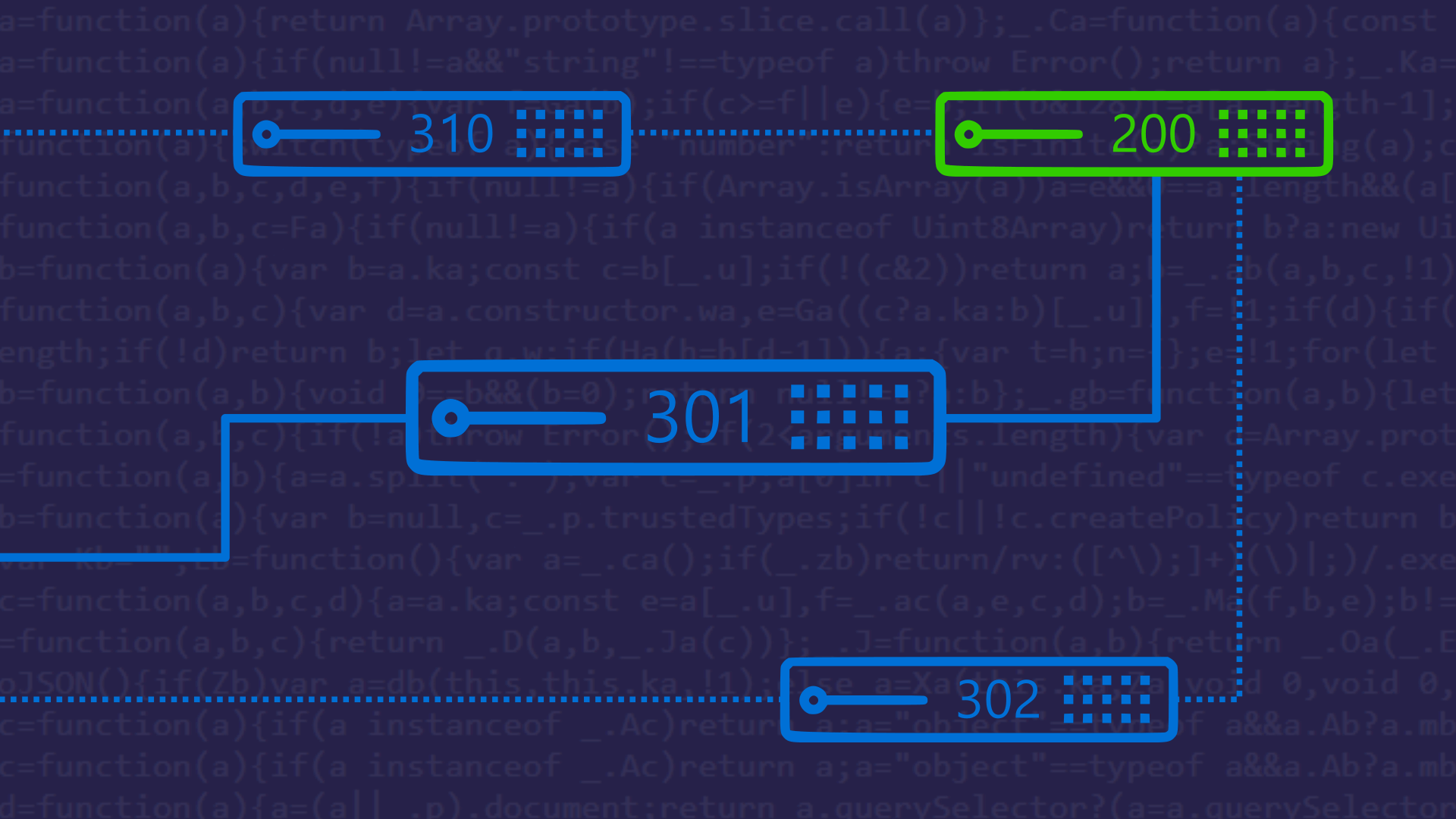

Przekierowania

Przekierowania mogą być szkodliwe pod kątem optymalizacji SEO, jeśli są niewłaściwie stosowane lub nadużywane. Przekierowanie 301 to najczęściej zalecana metoda przekierowania stron. Polega ona na trwałym przekierowaniu jednej strony na inną. Jednak w przypadku przekierowań 301 część mocy linków, które kierowały na pierwotną stronę, może zostać utracona. Przekierowania niepotrzebnie wydłużają czas ładowania strony. Kiedy użytkownik klika na link, a następnie przechodzi przez kilka przekierowań, każde przekierowanie wymaga czasu na przetworzenie i przesłanie odpowiedzi serwera. Długotrwałe ładowanie strony może prowadzić do frustracji użytkowników i negatywnie wpływać na ich doświadczenie. Ponadto, Google i inne wyszukiwarki również biorą pod uwagę czas ładowania strony jako czynnik rankingowy, więc przekierowania mogą wpływać na pozycjonowanie. Gdy przekierowanie jest używane, roboty wyszukiwarek muszą przejść przez dodatkowy krok, aby dotrzeć do docelowej strony. W przypadku dobrze zoptymalizowanych przekierowań, które są bezpośrednie i niezawodne, nie będą miały negatywnego wpływu na crawl budget. Roboty wyszukiwarek będą kontynuować indeksowanie strony w sposób płynny i skuteczny. Jednakże nieprawidłowo skonfigurowane przekierowania lub nadmiar przekierowań mogą negatywnie wpływać na crawl budget. Jeśli strona ma wiele przekierowań łańcuchowych lub pętli przekierowań, roboty wyszukiwarek mogą spędzić znaczną część swojego czasu na przechodzeniu między stronami, zamiast indeksować ich zawartość. To może prowadzić, do mniejszej liczby zaindeksowanych stron niż oczekiwano.

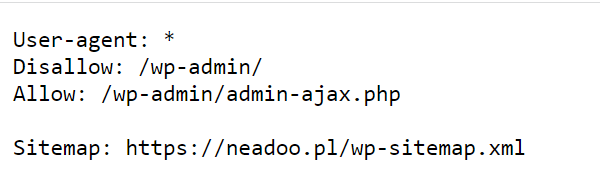

Pliki sitemap.xml i robots.txt

Pliki sitemap.xml i robots.txt są istotne pod względem SEO (Search Engine Optimization), ponieważ pomagają wyszukiwarkom internetowym lepiej zrozumieć strukturę i zawartość witryny.

- Plik sitemap.xml zawiera listę wszystkich stron dostępnych na stronie internetowej. Jest to rodzaj mapy witryny, która pomaga wyszukiwarkom zindeksować wszystkie strony witryny i zrozumieć ich hierarchię. Gdy wyszukiwarka odwiedza plik sitemap.xml, może łatwo znaleźć nowe lub zaktualizowane strony, co pomaga w szybszym indeksowaniu witryny. To z kolei zwiększa szanse na wyświetlanie stron w wynikach wyszukiwania.

- Plik robots.txt jest plikiem tekstowym umieszczanym w katalogu głównym witryny. Informuje on roboty wyszukiwarek, jakie części strony mają być indeksowane lub zignorowane. Dzięki plikowi robots.txt można określić, które foldery lub pliki nie powinny być indeksowane przez wyszukiwarki. Na przykład, jeśli w witrynie istnieje folder z plikami administracyjnymi, można go wykluczyć z indeksowania, aby utrzymać poufność danych. Plik robots.txt umożliwia również wskazanie lokalizacji pliku sitemap.xml, co ułatwia wyszukiwarkom odnalezienie mapy witryny.

Błędy 4xx

Błędy 4xx to odpowiedzi serwera, które wskazują na to, że żądanie klienta nie może zostać zrealizowane ze względu na błąd po stronie klienta. Są to błędy klienckie, takie jak błąd 404 – strona nie znaleziona, błąd 403 – dostęp zabroniony, błąd 401 – wymagane uwierzytelnienie, itp. Te błędy mają negatywny wpływ na SEO i efektywność Twojej witryny pod wieloma względami. Błędy 4xx, takie jak błąd 404, są frustrujące dla użytkowników. Gdy użytkownik trafia na stronę, która nie istnieje lub nie ma do niej dostępu, może odczuwać negatywne wrażenia i opuszczać Twoją witrynę. To może prowadzić do zwiększonej współczynnika odrzuceń (bounce rate) i obniżonej konwersji.Powtarzające się błędy 4xx na Twojej witrynie mogą wysyłać negatywne sygnały do wyszukiwarek, sugerujące, że Twoja strona może mieć problemy techniczne lub być niedopracowana. To może obniżyć ogólną wartość SEO Twojej witryny i wpływać na pozycje w wynikach wyszukiwania.

Błędy 5xx

Błędy 5xx to kody odpowiedzi serwera HTTP, które wskazują na problemy techniczne lub błędy po stronie serwera. Te błędy, takie jak błąd 500 Internal Server Error, 502 Bad Gateway, 503 Service Unavailable czy 504 Gateway Timeout, mają negatywny wpływ na SEO (Search Engine Optimization) z kilku powodów. Błędy 5xx powodują, że wyszukiwarki napotykają problemy podczas indeksowania stron. Kiedy robot wyszukiwarki napotyka błąd serwera, może zdecydować się nieindeksować danej strony lub odłożyć indeksowanie na później. To oznacza, że Twoja strona może zostać pominięta w wynikach wyszukiwania lub będzie indeksowana z opóźnieniem, co negatywnie wpływa na widoczność Twojej witryny w wyszukiwarkach. Błędy 5xx prowadzą do negatywnego doświadczenia użytkownika, gdy użytkownik odwiedza Twoją stronę. Jeśli strona nie jest dostępna z powodu takiego błędu, użytkownik może zrezygnować z jej odwiedzenia i zamiast tego szukać informacji na konkurencyjnych stronach.

Podsumowanie

Poprawne i dokładne przeprowadzenie, a następnie wdrożenie zmian z audytu on-site SEO jest niezwykle istotnym aspektem w kontekście pozycjonowania stron internetowych. Warto wspomóc się przy tym odpowiednimi narzędziami, takimi jak Google Search Console, Google Page Speed Insights czy Screaming Frog SEO Spider. W artykule zostały opisane najważniejsze rzeczy do sprawdzenia podczas takiego audytu – należy jednak pamiętać, że często to nie wystarczy i trzeba sprawdzić wiele innych bardziej zaawansowanych punktów. Jeśli szukasz specjalistów, którzy przeprowadzą profesjonalny audyt on-site SEO Twojej witryny, skontaktuj się z nami. Zachęcamy również do przeczytania innych artykułów powiązanych z tematyką pozycjonowania stron internetowych na naszym blogu.